OpenAI представила GPT-4: Он может интерпретировать изображения и решает задачи лучше ChatGPT

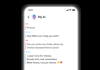

OpenAI представила GPT-4 — новую модель ИИ, которая может интерпретировать изображения и тексты. Можно, например, показать ИИ изображение с мемом и спросить, о чем этот мем, — и он объяснит.

Можно также спросить ИИ, что изображено на фотографии или что необычного в ней, — и получить четкое и понятное объяснение.

GPT-4 также может интерпретировать относительно сложные изображения, например, он может идентифицировать адаптер кабеля Lightning по изображению подключенного iPhone.

Чем GPT-4 отличается от GPT-3.5?

Модель GPT-3.5 работала только с текстом, а GPT-4 может «понимать» и текст, и изображения. По словам разработчиков, в различных профессиональных и академических тестах он даже работает на «уровне человека»: на экзаменах Uniform Bar Exam, LSAT, SAT Math и SAT Evidence-Based Reading & Writing GPT-4 набрал 88% и более. Мало кто из людей может получить такие результаты.

На настройку GPT-4 потребовалось около 6 месяцев, и при этом OpenAI использовала и программы состязательного тестирования, и помощь другого своего творения — ChatGPT. В результате удалось получить модель, которая на 82% реже отвечает на запросы о запрещенном контенте и на 40% чаще генерирует корректные ответы.

По словам разработчиков, при обычном диалоге разница между GPT-3.5 и GPT-4 может быть практически незаметной. Но если дать обеим моделям более сложную задачу, GPT-4 будет более надежен и креативен — он сможет обрабатывать гораздо более тонкие инструкции, чем GPT-3.5.

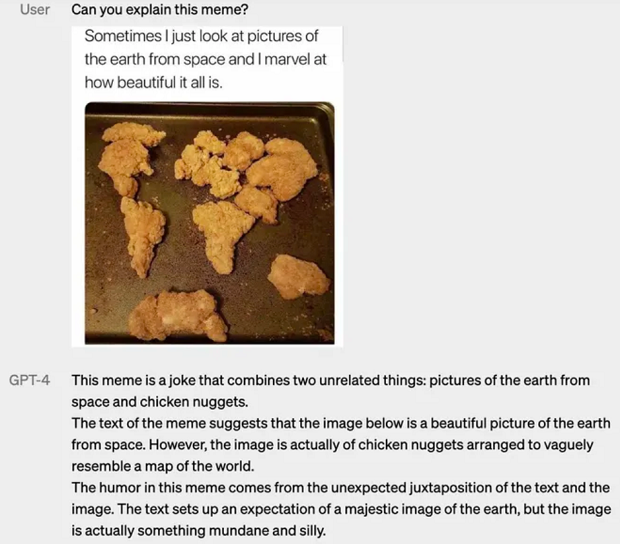

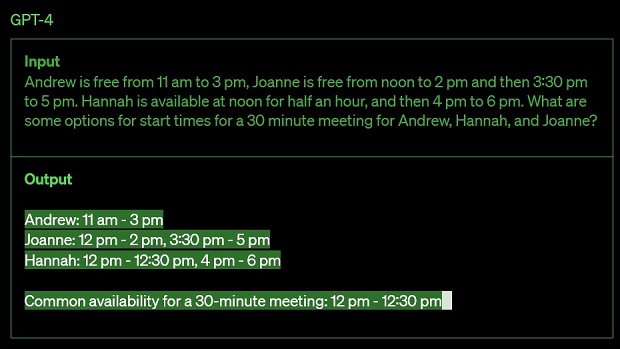

Если дать одну и ту же задачу GPT-4 и основанному на GPT-3.5 ChatGPT, ответ GPT-4 будет более точным и обоснованным.

Вот как обе модели ИИ отвечают на вопрос о том, когда Эндрю, Джоанна и Ханна могут встретиться на полчаса, если Эндрю свободен с 11:00 до 15:00, Джоанна свободна с полудня до 14:00, а затем с 15:30 до 17:00, а Ханна доступна в полдень в течение получаса, а затем с 16:00 до 18:00. GPT-4 ожидаемо дает более правильный ответ.

Виртуальный волонтер

В настоящее время OpenAI тестирует свое новое творение с Be My Eyes. Новая функция «Виртуальный волонтер» на базе GPT-4 может отвечать на вопросы об отправленных ей изображениях.

Например, пользователь может показать ИИ фотографию содержимого своего холодильника, и виртуальный волонтер сможет не только правильно определить, какие продукты есть в холодильнике, но и проанализировать, что из них можно приготовить. Инструмент предложит ряд рецептов и пошаговое руководство по готовке.

Он пока не идеален

По словам разработчиков, GPT-4 пока далеко не идеален и вполне может ошибаться. Например, чат-бот как-то назвал Элвиса Пресли «сыном актера» — это очевидная ошибка.

Иногда чат-бот может совершать простые логические ошибки в своих суждениях. Также он может быть слишком легковерным и принимать очевидные ложные утверждения от пользователя за правдивые.

Кроме того, как и ChatGPT, GPT-4 не знает о событиях, которые произошли после сентября 2021 года. Однако по сравнению с GPT-3.5 у новой модели есть очевидные преимущества.

По словам генерального директора OpenAI Сэма Альтмана, GPT-4 не будет самой большой языковой моделью. Более того, по его мнению, человечеству еще далеко до разработки совершенного ИИ.

Как получить доступ к GPT-4?

GPT-4 доступна через API OpenAI по списку ожидания, а также в ChatGPT Plus, премиум-плане ChatGPT.

- Также по теме

- Google уволила 28 сотрудников, протестовавших против сотрудничества компании с Израилем

- Meta представляет Llama 3 и утверждает, что это «самая мощная» языковая модель с открытым исходным кодом

- В WhatsApp будет внедрена функция искусственного интеллекта: Что она будет делать?

- Чем опасно общение детей с нейросетями и голосовыми помощниками?

- Boston Dynamics представила новую, полностью электрическую версию робота Atlas: Где он будет применяться?

- Доступ к интернету не потребуется? Как будет работать ИИ в iPhone

- Самые читаемые

месяц

неделя

день

- В WhatsApp будет внедрена функция искусственного интеллекта: Что она будет делать? 6145

- WhatsApp получит новую и полезную функцию 2955

- 5 лучших смартфонов с IPS-экранами 2049

- 10 самых интересных архитектурных работ Захи Хадид 1715

- 5 оригинальных зданий с любопытными оптическими иллюзиями (фото) 1481

- 3 лучших смартфона до 100 долларов 1311

- Вместо того, чтобы уничтожить почти 100 000 старых iPhone, канадская компания продала их в Китае 1259

- Почему сегодня так сложно отправить людей на Луну? 1236

- Такое бывает лишь раз в жизни: В этом году мы сможем невооруженным глазом наблюдать вспышку звезды, произошедшую 3000 лет назад 1230

- Представлена первая в мире банковская карта с экраном: Kак это работает? 1128

- Читайте также

- Архив