Մարդկանց մեծ մասը չի կարողացել տարբերել Sora նեյրոցանցի ստեղծած տեսանյութերն իրականից

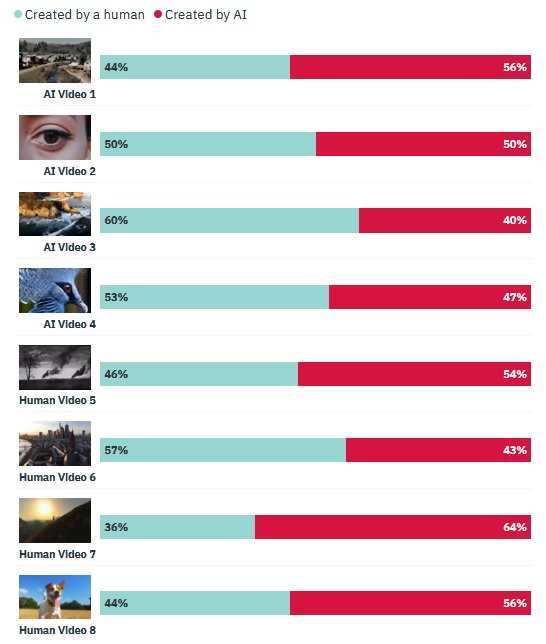

Մի քանի շաբաթ առաջ Open AI ընկերությունը ներկայացրեց Sora նեյրոցանցը, որը տեքստային նկարագրության հիման վրա մինչև մեկ րոպե տևողությամբ (1920 × 1080 պիքսել կետայնությամբ) իրատեսական տեսանյութեր է ստեղծում։ Այժմ HarrisX ընկերությունը հարցում է անցկացրել ամերիկացի մեծահասակների շրջանում՝ խնդրելով տարբերակել արհեստական բանականության (ԱԲ) միջոցով ստեղծված տեսանյութերն իրականից: Պարզվել է, որ հարցվածների մեծ մասը սխալվել է և չի կարողացել տարբերել ԱԲ-ով ստեղծվածներն իրականից։

Մարտի 1-ից 4-ը ԱՄՆ-ում անցկացված հարցմանը մասնակցել է ավելի քան 1000 ամերիկացի։ Հետազոտության հեղինակները ստեղծել են չորս բարձրորակ տեսանյութ՝ օգտագործելով Sora նեյրոցանցը, ինչպես նաև ընտրել են չորս կարճ տեսանյութեր, որոնք նկարահանվել են իրական աշխարհում: Հարցվողներին այդ տեսանյութերը ցուցադրվել են պատահական կարգով, և նրանց նպատակն է եղել պարզել՝ տեսանյութը մարդո՞ւ կողմից է արված, թե՞ ԱԲ-ի: Հարցման մասնակիցների կարծիքները տարբեր են եղել, սակայն ութ դեպքից հինգում հարցվածների մեծ մասը տվել է սխալ պատասխան։

Ինչպես գրում է Variety պարբերականը, այս հետազոտությունը ցույց է տալիս, որ գեներատիվ նեյրոցանցերի միջոցով ստեղծված բովանդակությունը գնալով ավելի իրատեսական է դառնում, և այն իրականից տարբերելը գնալով ավելի է դժվարանում: Այդ իսկ պատճառով տարբեր երկրներում հաճախակի են դարձել այս ոլորոտի օրենսդրական կարգավորման անհրաժեշտության մասին իշխանություններին ուղղված կոչերը։ Ի թիվս այլ բաների, առաջարկվում է նեյրոցանցեր օգտագործողներին պարտավորեցնել, որ համապատասխան կերպով նշեն գեներացված բովանդակությունը, որպեսզի այն չմոլորեցնի մյուսներին և չդառնա ապատեղեկատվության աղբյուր։

Sora ալգորիթմը դեռ հասանելի չէ լայն հանրությանը, սակայն այն արդեն լուրջ մտահոգություն է առաջացնում հասարակության շրջանում, հատկապես զվարճանքի ոլորտում, որտեղ վիդեո բովանդակության ստեղծման տեխնոլոգիաների զարգացումը շատ բացասական հետևանքներ է առաջացնում, օրինակ՝ կինոստուդիաների համար։ Բացի դրանից՝ ավելի ու ավելի է բարձրացվում այն հարցը, որ Sora-ի նման ալգորիթմները կարող են օգտագործվել քաղաքական գործիչների և հայտնի մարդկանց մասնակցությամբ կեղծ տեսանյութեր ստեղծելու համար, ինչը կարող է հանգեցնել ամենաանկանխատեսելի հետևանքների:

- Այս թեմայով

- Ութ խոշոր թերթեր OpenAI-ին և Microsoft-ին դատի են տվել ԱԲ զարգացման նպատակով իրենց բովանդակությունն ապօրինաբար օգտագործելու համար

- Ներկայացվել է ռոբոտ, որն ուտեստ է պատրաստում, մատուցում, գինի լցնում, արդուկ անում, ծալում արդուկած շորերը

- Google-ի Gemini ԱԲ-ն արդեն հասանելի է Android-ի հին տարբերակների համար

- Google-ն աշխատանքից ազատել է 28 աշխատակցի, որոնք բողոքել են Իսրայելի հետ ընկերության համագործակցության դեմ

- Meta-ն ներկայացրել է Llama 3-ը և պնդում է, որ այն բաց կոդով «ամենահզոր» լեզվական մոդելն է

- WhatsApp-ում արհեստական բանականության գործառույթ կներդրվի․ ի՞նչ է այն անելու

- Ամենաընթերցվածը

ամիս

շաբաթ

օր

- Ապոկալիպսիս. ե՞րբ և ինչպե՞ս կկործանվի Երկիր մոլորակը (վիդեո) 4176

- Ինսայդերը ցուցադրել է iPhone 16-ի բոլոր 4 մոդելների մակետները՝ առջևից և հետևից 2792

- Ակնկալիք vs իրականություն. ինչպես է իրականում աշխատում փորձնակությունը միջազգային ընկերությունում 2579

- iPhone 16-ի հետևի վահանակը կարող է 7 գույնի փայլատ ապակի ստանալ 2296

- Ի՞նչ կլինի Երկրի հետ, եթե Լուսինն անհետանա 2142

- Զահա Հադիդի ճարտարապետական 10 ամենահետաքրքիր աշխատանքները 1974

- WhatsApp-ում նոր օգտակար գործառույթ է ավելացվել 1938

- ՏՏ ոլորտի խոշոր հարկատուները․ ի՞նչ փոփոխություններ են գրանցվել 2024-ի 1-ին եռամսյակում 1665

- iPhone-ների վաճառքը Չինաստանում կրճատվել մոտ 20%-ով․ ի՞նչն է պատճառը 1577

- ՌԴ-ում սմարթֆոնը բռնկվել է անմիջապես երեխայի ձեռքում 1573

- Արխիվ