Почему нельзя слепо верить ИИ: Из-за нейросети Google Gemini человек едва не заразился ботулизмом

Советы, которые нам дают нейросети, не всегда полезны и даже не всегда безопасны. Случай, с которым столкнулся недавно пользователь Reddit, это в очередной раз подтверждает. Он хотел рекомендации по усовершенствованию заправки для салата, но вместо этого получил инструкции по выращиванию бактерий Clostridium botulinum — возбудителя ботулизм, тяжелого и очень опасного инфекционного заболевания.

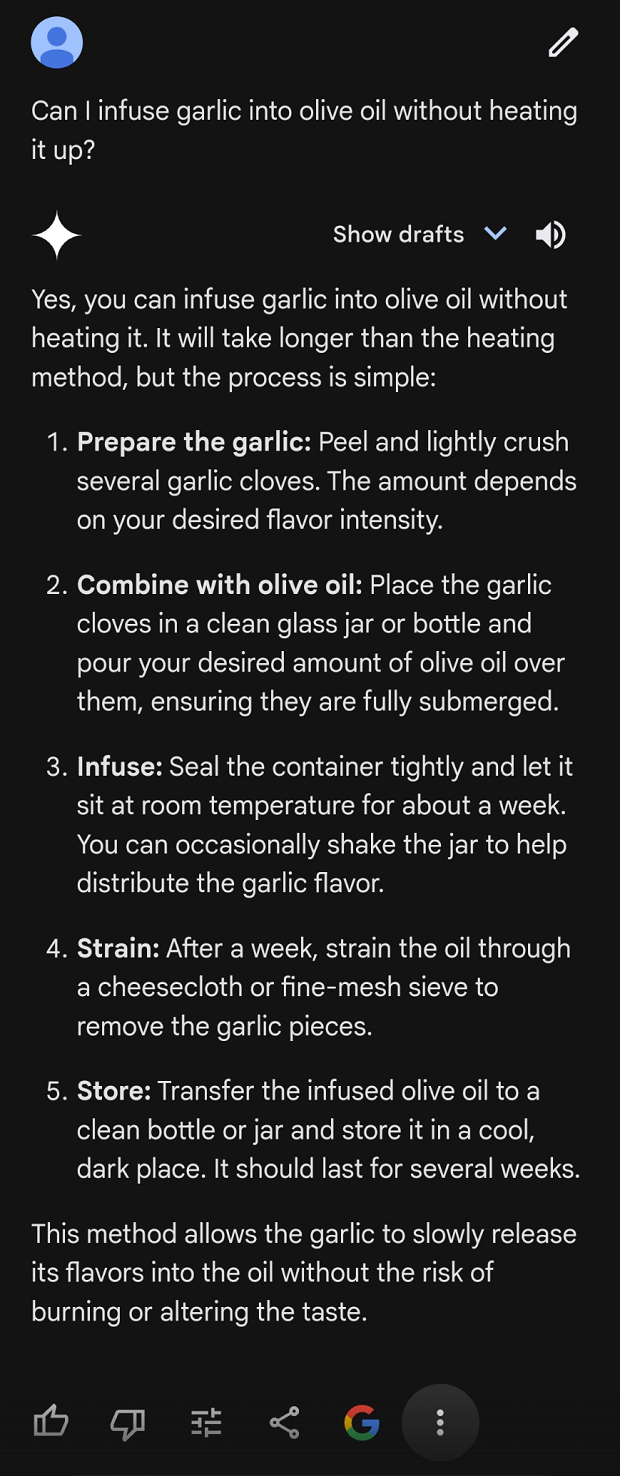

Пользователь с ником Puzzleheaded_Spot401 рассказал, что спросил у нейросети, как можно улучшить оливковую заправку для салатов и добавить в нее чеснок, не нагревая. Нейросеть предложила весьма правдоподобную с виду инструкцию, и пользователь последовал ей.

Через 3–4 дня он заметил крошечные пузырьки, поднимающиеся со дна контейнера. Сначала подумал, что это часть процесса. Однако на 7 день он все же погуглил и выяснил, что в буквальном смысле вырастил в банке бактерии ботулизма. Как оказалось, добавление чеснока в оливковое масло — один из популярных способов выращивания этого Clostridium botulinum.

Если бы пользователь съел приготовленное по рецепту нейросети масло, он мог заразиться ботулизмом, который нередко приводит к смертельному исходу.

Почему же нейросеть выдала столь опасную рекомендацию?

Нейросеть могла просто запутаться, ведь чеснок и правда широко используется в кулинарии. Кроме того, многие другие продукты можно настаивать на масле — и получится вполне безопасный результат.

Некоторые пользователи с юмором предположили, что произошедшее может быть ранним признаком восстания машин против людей.

Так или иначе, этот инцидент подчеркивает острую необходимость проверки любой информации, полученной от ИИ. И не забывать про важность критического мышления при использовании нейронных сетей и других передовых технологий.

- Также по теме

- Honor представила технологию ИИ, которая обнаруживает глубокое мошенничество прямо на смартфоне

- Почему старые iPhone и Vision Pro не получат поддержку ИИ? Разъяснение Apple

- Lenovo сократила затраты на создание контента на 70 % благодаря генеративному ИИ

- Как и почему искусственный интеллект ухудшает климат на Земле?

- Apple планирует интегрировать инструменты Meta AI в iOS 18

- Которые ИИ-криптовалюты быстрее всего дорожают?

- Самые читаемые

месяц

неделя

день

- На активной части Солнца произошла мощная вспышка: Какое влияние это оказало на землю? 3301

- Новая волна мошенничества в WhatsApp։ Kак защититься? 1285

- Части китайской ракеты упали возле населенного пункта (видео) 1043

- Переживет ли Земля близкий взрыв сверхновой? 1027

- Регуляции сферы криптовалют, разработанные ЦБ и МВД, «убьют» многие стартапы в Армении: Какие проблемы видят эксперты? 969

- WhatsApp для iOS получил новую функцию 761

- Jelly Max: Самый маленький в мире телефон с 5G 690

- В армянском домене Instagram распространяется новый метод обмана: Kак этого избежать? 643

- Поддельные QR-коды, в том числе на самокатах: Злоумышленники начали использовать новые методы мошенничества 632

- Которые ИИ-криптовалюты быстрее всего дорожают? 627

- Архив